Experten-Blog

Automatisierte Prozesskontrolle in der Matrix

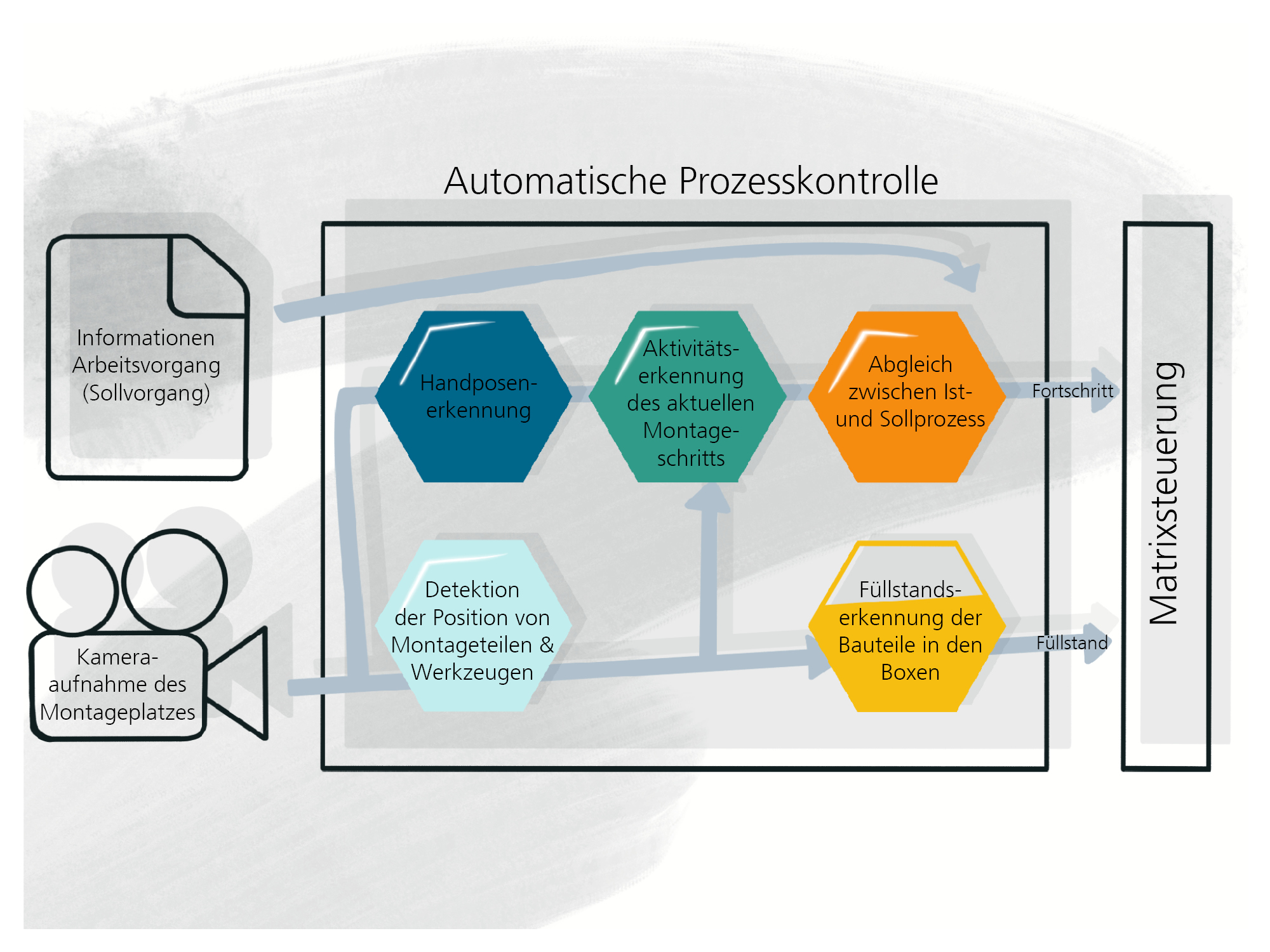

Um manuelle Montageprozesse in die komplexe Matrixproduktion zu integrieren, werden Systeme benötigt, die automatisiert den Zustand des Prozesses erkennen und an die Steuerung der Matrix zurückgeben können. Damit können abhängige Produktionsschritte in anderen Matrixzellen der aktuellen Situation angepasst werden. Wie sieht ein solches System aus, das die Interaktionen des Menschen mit Werkzeugen und Bauteilen erkennt und versteht? Wie können aktuelle KI-Methoden hier unterstützen?

KI-basierte Bildverarbeitung in der Matrixproduktion

Montageprozesse können enorm vielfältig aussehen und unterschiedlichste Vorgänge beinhalten. Auch Umgebungsbedingungen, Werkzeuge und Personen wechseln ständig. Ein Mensch kann diese Vorgänge ohne Probleme verstehen und analysieren. Stellen Sie sich vor, man würde eine zusätzliche Person, die über alle Vorgänge informiert ist, in die Matrixzelle stellen. Diese könnte dem Monteur Feedback geben, Füllstände und Prozessfortschritt an die Steuerung melden und weitere Unterstützung bieten. Diese Informationen können helfen, die Matrixproduktion flexibel anzupassen und optimal zu steuern. Da aber eine solche Tätigkeit durch einen Menschen aufwendig, teuer und somit nicht praktikabel ist, muss ein anderer Ansatz entwickelt werden: Ein computergestütztes, kamerabasiertes System, das diese Funktionen umsetzt. Hierbei helfen uns neueste Ansätze im Bereich der KI, um ein solches System aufzubauen. Die Schwierigkeit besteht hier darin, unterschiedliche KI-Methoden so zu kombinieren, dass man möglichst flexibel und exakt Informationen aus dem laufenden Prozess extrahieren kann. Um das System möglichst einfach in bestehende Montagezellen integrieren zu können, wird auf einen einzelnen Kamerasensor gesetzt, der den Arbeitsbereich vollständig erfassen kann und sowohl 2D-Farbbilder als auch Tiefenbilder kontinuierlich aufnehmen kann. Auf diesen Videodaten werden moderne Bildverarbeitungsalgorithmen angewandt.

Aktivitätserkennung auf Basis von Gelenkpositionen

Eine der Hauptkomponenten des Systems zur automatisierten Prozesskontrolle ist die Aktivitätserkennung von Montageprozessen. Das Ziel ist hier, zu erkennen, welcher Montageschritt im Moment vom Werker ausgeführt wird. Dieser Ist-Zustand kann dann mit dem hinterlegten Soll-Prozess bzw. der korrekten Abfolge von Montageschritten abgeglichen werden. Bei einer Abweichung kann das dem Werker mitgeteilt werden, sodass dieser korrigierend eingreifen kann. Zudem kann der Fortschritt der Montage an die Steuerung weitergeleitet werden, sodass bspw. ein fahrerloses Transportsystem zur Abholung an der Montagezelle angefordert werden kann.

Aber wie funktioniert diese Aktivitätserkennung? Zunächst müssen aus den 2D-Videodaten der Kamera sogenannte „High-Level“ Informationen abgeleitet werden. Das heißt, aus den vielen tausend Pixeln im Bild müssen sinnvolle Daten herausgefiltert werden, die das wesentliche im Bild beinhalten und für die Aktivitätserkennung relevant sind. Hierzu werden Positionsdaten der einzelnen Gelenke der Hände und Finger aus den Bildern geschätzt, da deren Bewegungen und damit auch Montageaktivitäten dadurch sehr gut repräsentiert werden können. Dieser Verarbeitungsschritt geschieht mithilfe eines KI-Modells, das zuvor auf tausenden Bildern von Personen mit bekannten Gelenkpositionen trainiert wurde. Ein nachgeschaltetes KI-Modell wird dann mit einer Sequenz dieser Gelenkpositionen trainiert, sodass es darauf den jeweiligen Montageprozess vorhersagen kann.

Allerdings fehlt nach diesen Schritten noch der genaue Kontext für die Aktivität. Mit welchem Werkzeug und mit welchem Bauteil wurde z. B. die Aktion „Schraubbewegung“ durchgeführt? Um diese Funktionalität umzusetzen, wird ein Objektdetektor-KI-Modell eingesetzt. Damit können unterschiedlichste Objekte wie Schrauben, Werkzeuge und weitere Objekte erfasst werden. In Kombination mit der bekannten Aktion des Werkers und den erkannten Objekten kann daraus dann die konkrete Aktivität bestimmt werden.

Füllstandserkennung durch Objekterkennung und synthetische Datenerzeugung

Als weitere Hauptkomponente wird eine Füllstandserkennung entwickelt, die es Matrix-Produktionssystemen ermöglicht, die Menge an Bauteilen am Arbeitsplatz automatisch zu erkennen und die Matrixsteuerung entsprechend anzupassen. Die Füllstandserkennung überwacht den Füllstand mithilfe desselben Kamerasensors, der auch für die Aktivitätserkennung eingesetzt wird. Zusätzlich zu den 2D-Farbbildern werden aber auch die Tiefenbilder hinzugezogen.

Zur Bestimmung des Füllstands wird wie bei der Aktivitätserkennung ein KI-Objektdetektor-Modell mit gesammelten und annotierten Daten trainiert. Dieser Objektdetektor ermöglicht die Zählung der Komponenten pro Box auf Basis von 2D-Farbbildern. Dies funktioniert problemlos für eine geringe Anzahl an Komponenten in der Box, wird jedoch wesentlich herausfordernder, sobald die Box voll mit kleinen Komponenten wie Schrauben ist, die sich mehrfach überlagern und überdecken. Daher werden zusätzlich Tiefenbilder in die Methode zur Füllstandserkennung einbezogen. Ein Tiefenbild enthält Informationen über den Abstand der Oberflächen von Bauteilen zur Kamera. Durch die Information aus dem Tiefenbild über die Füllhöhe der Box kann auf den Füllstand geschlossen werden. Hierbei ist eine Herausforderung, dass die Tiefenauflösung für sehr kleine Objekte nicht ausreicht. Daher werden beide Ansätze (2D + Tiefenbild) kombiniert, um bei beliebigen Mengen von Bauteilen den Füllstand korrekt erkennen zu können. Mithilfe dieser Methode kann ein zur Neige gehender Vorrat an Bauteilen frühzeitig und automatisch an die Matrixsteuerung gemeldet werden und eine Unterbrechung der Produktion vermieden werden.

Aufwand für Datenaufbereitung und Training minimieren

Beim Trainieren der KI-Modelle für beide Anwendungen sind Datenqualität und die Menge der Daten eine große Herausforderung. Um das Annotieren der Daten zu erleichtern oder komplett zu vermeiden, werden von uns mehrere Methoden eingesetzt:

- Generieren von synthetischen Daten (kein Annotierungsaufwand)

- Unterstütztes Annotieren durch Objekttracking (geringer Aufwand für Annotierung)

- Augmentierung von Daten (kein Annotierungsaufwand)

Zu diesen Methoden haben wir Software-Tools entwickelt, die uns bei der Erfassung und Aufbereitung von Daten unterstützen. Dies ist notwendig, da letztlich große Mengen an qualitativ hochwertigen Daten essenziell sind, um die Möglichkeiten von KI auszuschöpfen.

Zukunft der Bildverarbeitung in der Matrixproduktion

Unsere im Projekt SE.MA.KI entwickelten Methoden zur automatischen Prozesserkennung sind ein wichtiger Bestandteil der komplexen KI-gestützten Matrixproduktion von morgen. Bildverarbeitung ist dabei ein elementarer Bestandteil sowie eine notwendige Schnittstelle zwischen digitaler und realer Welt, um manuelle Prozesse in die automatische Matrixproduktion zu integrieren. Zukünftig wollen wir die erarbeiteten Methoden weiter optimieren und insbesondere den Aufwand für das Training der Modelle mit synthetischer Datenerzeugung und unterstütztem Annotieren weiter stark reduzieren. Auch die Assistenzfunktionen unseres Systems können weiter ausgebaut werden, um den Werker in seiner Arbeit intelligent zu unterstützen und die Produktion effektiver zu gestalten.

Dieses Forschungs- und Entwicklungsprojekt wird durch das Bundesministerium für Bildung und Forschung (BMBF) gefördert (Förderkennzeichen: L1FHG42421). Die Verantwortung für den Inhalt dieser Veröffentlichung liegt bei den Autor:innen.

Fraunhofer-Verbund Produktion

Fraunhofer-Verbund Produktion